El mundo de las computadoras con una capacidad exponencial para operar se superó sucesivas veces en los últimos tiempos; qué puede venir, según los analistas

El debate sobre la agenda de futuro está, al igual que

sucede con la economía o las decisiones en la vida cotidiana, repleto de

sesgos. Uno muy habitual consiste en creer que el punto de explosión de una

tecnología se da cuando esta equipara a los mejores humanos en eficiencia y

calidad, cuando, en realidad, el derrame se produce a partir de

resultados que son “lo suficientemente buenos” para la mayor parte de la

población.

Rebobinemos la historia por un par de párrafos: la

computación cuántica fue anticipada en un famoso discurso del físico Richard

Feynman a principios de los 80. En la computación tradicional, los

bits pueden ser 1 o 0, pero en la cuántica los qbits pueden superponerse y

adoptar muchos más valores, con lo cual la capacidad de cómputo –para

algunos problemas– se multiplica exponencialmente.

Durante décadas, la predicción de Feynman fue solo teórica,

porque la inestabilidad y el “ruido” de los sistemas de qbits los volvían un

desafío ingenieril casi imposible de resolver. Pero en 2021 llegaron muy buenas

noticias por el lado del hardware, e incluso se anunciaron nuevas tecnologías

que permiten estabilizar los qbits sin tener que ir a temperaturas extremas

bajo cero, lo que elevaba el costo de estos ordenadores a decenas de millones

de dólares.

El panorama cambió drásticamente en los últimos tres años,

a tal punto que en este ambiente se habla de “los viejos tiempos” para

referirse a… ¡2018!

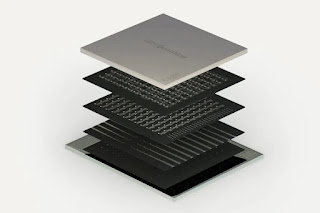

Google logró la supremacía con una máquina de 54 qbits, y en

noviembre IBM se anotó un nuevo récord, con una computadora cuántica (“Eagle”)

de 127 qbits.

“Están pasando cosas increíbles porque muchas disciplinas,

como la física, la geología, la biología y la geología, entre otras, se están

volcando masivamente a las ciencias de datos” (que son el lenguaje tanto de la

cuántica como de la IA), cuenta a la nacion Facundo Sapienza, que hizo las

carreras de Matemática y Física en Ciencias Exactas de la UBA en paralelo y que

actualmente cursa su doctorado en Berkeley. Su tesis fue sobre cuántica y en

Estados Unidos trabaja en IA. “La Argentina no tiene nada que envidiarle a

ningún país en talento de físicos, nuestras restricciones son económicas, por

ejemplo de falta de presupuesto para comprar instrumental en laboratorios”,

agrega Sapienza.

Además de las mencionadas IBM y Google, en esta carrera

están también –con distintos abordajes– Intel, Microsoft, Honeywell y IonQ, la

primera startup del rubro en hacer una oferta pública de acciones con un valor

inicial de US$2000 millones.

Se espera que pronto haga su IPO también la firma

californiana Rigetti. Su CEO, Chad Rigetti, sostuvo en un reciente

reportaje que en el entorno de los 100-200 qbits empezaremos a ver aplicaciones

comerciales interesantes, y defendió el concepto de “ventaja angosta” como

verdadera cota de disrupción. ¿Cuál será el primer sector en “enchufar” partes

cuánticas a sus procesos computacionales? Rigetti cree que el de los derivados

financieros. La industria farmacéutica sigue en la

cola de entusiasmo.

Luego del hito de la supremacía logrado por Sycamore a Google

con 54 qbits, hubo una demostración exitosa de 60 por parte de la Universidad

de Ciencias y Tecnología de China (USTC) en Hefei. Aquí el progreso no debe

leerse en forma lineal: un ordenador de 200 qbits no es “el doble” de

poderoso que uno de 100, sino más potente (y difícil de estabilizar) en varios

órdenes de magnitud. IBM espera llegar a los 400 qbits a fin de este

año y probablemente a los 1000 qbits en 2023.

“Es importante remarcar el hecho de que se sigue

estabilizando la tecnología y se sigue incrementando el rendimiento de

los procesadores cuánticos”, cuenta a LA NACION Román

Zambrano, CTO de IBM para la Argentina y Uruguay. Si tiene que nombrar las

áreas en las que cree que esta nueva tecnología será más impactante, cree que

no hay que dejar de considerar “el rendimiento de algoritmos de machine

learning para acelerar la explotación de datos y el desarrollo de

modelo de inteligencia artificial; la posibilidad de recrear ciertos procesos

que por su escala o complejidad son difíciles de representar en modelos

tradicionales, y la criptografía y la seguridad”.

Para Rigetti y otros expertos, el camino cuántico es

“la liana” a la cual la computación va a pasarse para poder seguir sosteniendo

la ley de Moore (crecimiento exponencial en la capacidad de cómputo)

que apalancó la revolución digital en las últimas décadas. Esta vez el camino

no pasará por seguir haciendo chips cada vez más diminutos, sino con un formato

completamente distinto.

En la literatura de innovación se habla de las “tecnologías

de propósito general” (TPG) para describir aquellas avenidas de avance que

tienen impacto en todos (o casi todos) los sectores de la economía. Lo fueron

la electricidad, el motor de combustión interna, la PC, internet o la

movilidad. En estos “años interesantes” hay varias TPG interactuando: la

IA, la descentralización (Web3) o la biotecnología, que va más allá del negocio

de la salud y tiene efectos sobre la energía, la alimentación, la

infraestructura, etcétera. La cuántica tal vez sea la TPG menos

conocida, la más críptica y difícil de descifrar, pero no por ello la menos

fascinante.

No hay comentarios:

Publicar un comentario